◆出展情報

まずは出展情報です。

2018年11月18日開催の「日本官能評価学会 2018年大会」に企業展示いたします。

今年はAI(人工知能)がメインテーマだそうです。

2016年のDrinkJapanで弊社が官能評価のディープラーニングをデモ展示したときは、他の分野に比べてあまりの無反応に驚いたのですが、ついに人工知能がメインテーマとなりました。嬉しいですね。

弊社では、機器データ等の処理にはディープラーニングを、官能評価の設計・解析等にはエキスパートシステム(古いなぁ・・)による人工知能システムを提案しております。

学生時代PROLOGなんてものもやりました(PROLOGは、数十年の人工知能ブームの中核となった言語です。)。

学会にご参加の方、お時間がありましたらお立ち寄りください。

◆JARスケールのASTMマニュアル本

さて、今回はJARスケールの規格のお話です。

近年人気となっているJARスケール(Just-About-Right scale)ですが、2009年にASTMからマニュアル本が出版されています。

(ISOはASTMに後れを取ることが多いようです。標準化という意味では落ち着くのを待つのもよいのですが、ISO規格で新しい手法を取り上げつつも詳細は文献を参照として、ASTMの該当規格をあげています)

JARスケールに特化した本というのは出版されていないので貴重な本だと思います。

タイトルと価格は下記の通りです。

MNL63「Just About Right (JAR) Scales: Design, Usage, Benefits, and Risks」120ページ $55(約6300円)

論文を探しても良いのですが、MNL63にはいろいろなアイデアが詰まっていて解析方針のアイデア出しにも有効です。

内容は最初の13ページがJARスケールの解説です。

以外と短いです。

しかし、歴史やメリット・デメリットなど基本的な知識が記載されているので13ページを読むだけでJARスケールの基礎知識は習得できます。

残りの100ページは、appendixです。驚きなのがappendixがAからZまであります。26項目ですね。

果たして「付録(appendix)かな?」というのが感想です。

JARデータの解析アプローチについて推奨・非推奨問わずに網羅している感じです。

各項目の最後にRecommendations(推奨事項)という項目があります。ここは必ず読みましょう。

なぜなら、使用状況をかなり限定している手法も掲載されています。つまり、通常では「非推奨」の解析アプローチということです。

解析アプローチで私が気になったものをピックアップしました。

ペナルティ分析を基本とした4つの手法です。

Appendix L:ペナルティ分析:

JARデータのスタンダードな解析手法。

Appendix O:ブートストラップ法によるペナルティ分析:

ペナルティ分析の応用。他分野でも活用されているブートストラップ法による推定。今後に期待の手法です。

Appendix P:機会分析:

回答者を4つのグループに分けてリスク(Risk)と機会(Opportunity)の比率を解析します。ペナルティ分析の次に行います。

Appendix Q:PRIMO分析:

PRoduct IMprovement Opportunity analysisの略。ベイズ統計を用いて最適化を図る手法です。ペナルティ分析の次に行います。

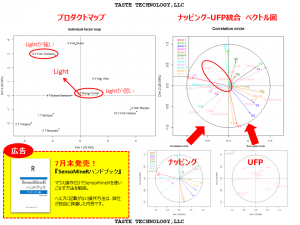

この他にもJARデータの検定、回帰分析、プロダクトマップ、プリファレンスマップ、理想点解析などの事例が掲載されています。

ご興味の方はお手元にいかがでしょうか?

◆テキストの取次店販売のお知らせ

最後に弊社テキスト本ですが、弊社から直接購入できない(したくない?)場合はどこかの取次店を通していただくことも可能です。その場合は1か月間のサポートサービスが受けられなくなりますが、弊社に購入時期と取次店名をご連絡頂ければサポートいたします。

今回はJARスケールのASTM規格のお話でした。